Mi a tisztességes?

Egyszerű kérdésnek tűnik, de egyszerű válaszok nélkül kérdés. Különösen igaz ez a mesterséges intelligencia (AI) arcán világában, ahol az intelligens, érzelmek nélküli gépek, amelyek csodálatosan torzításmentes döntéseket hoznak, gyorsan elhalványul.

Ennek a felfogásnak a talán a legnyilvánvalóbb zavarát egy 2016. évi ProPublica-vizsgálat követette, amely arra a következtetésre jutott, hogy a bírák által használt AI-rendszert vezetõ adatok annak megállapítására, hogy az elítélt bûnözõ valószínûleg több bűncselekményt követ el-e, elõrehaladták a kisebbségeket. A COMPAS néven ismert algoritmust készítő Northpointe, a ProPublica az eredmények értelmezését vitatta, ám az összecsapás vitát és elemzést váltott ki arról, hogy még a legokosabb gépekbe is meg kell-e bízni.

"Ez egy nagyon forró téma - hogyan lehet az algoritmusokat igazságossá és megbízhatóvá tenni" - mondja Daniel Neill. "Ez egy fontos kérdés."

Neill most a vita közepén helyezkedik el. A Carnegie Mellon Egyetem számítástechnikája, ő és egy másik kutató, Will Gorr több évvel ezelőtt kifejlesztett egy CrimeScan nevű bűncselekmény-előrejelző szoftvert. Eredeti koncepciójuk az volt, hogy bizonyos esetekben az erőszakos bűnözés olyan, mint egy fertőző betegség, és hogy hajlamos a földrajzi klaszterekben kibontakozni. Azt is hitték, hogy a kevésbé elkövetett bűncselekmények az erőszakosabb cselekedetek hordozói lehetnek, ezért elkészítették az algoritmust, amely sokféle „vezető mutató” adatot tartalmaz, beleértve a bűncselekményekről szóló beszámolókat, például egyszerű támadások, vandalizmus és rendellenes magatartás, valamint 911 olyan eseményekről szól, mint például lövések vagy fegyverrel látott személyek. A program magában foglalja a szezonális és a heti nap tendenciáit, valamint a súlyos erőszakos bűncselekmények rövid és hosszú távú arányát.

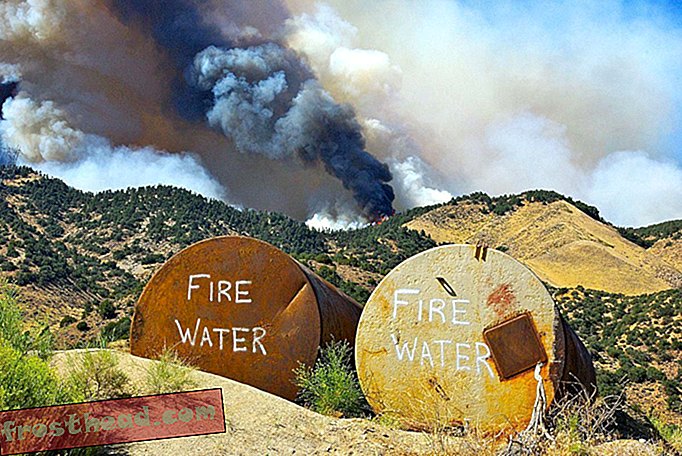

Az ötlet az, hogy nyomon kövesse a szikrákat, mielőtt a tűz kitörne. "Több kisebb bűncselekményt vizsgálunk" - mondja Neill. Az egyszerű támadások megnehezíthetők a súlyosbodó támadásokig. Vagy lehet, hogy két bandája között fokozódó erőszakos mintázatot mutat.

Előrejelzés, mikor és hol

A CrimeScan nem az első olyan szoftver, amelyet a prediktív rendőrségre terveztek. A PredPol nevű programot nyolc évvel ezelőtt hozták létre a Los Angeles-i Rendőrséggel együttműködő UCLA tudósok azzal a céllal, hogy megfigyeljék, hogy a bűncselekményekre vonatkozó adatok tudományos elemzése hogyan segítheti elő a bűnözés magatartásának mintáit. A PredPol, amelyet az országban több mint 60 rendőri osztály használ, a környéken azonosítja azokat a területeket, ahol egy adott időszakban valószínűleg súlyos bűncselekmények fordulnak elő.

A cég szerint kutatása szerint a szoftver kétszer pontosabb, mint az emberi elemzőknél, amikor előre kell mondani, hogy hol fog elkövetni a bűncselekmény. Egyetlen független tanulmány azonban nem erősítette meg ezeket az eredményeket.

Mind a PredPol, mind a CrimeScan korlátozza előrejelzéseit arra, hogy ahol a bűncselekmények bekövetkezhetnek, és elkerüli a következő lépést annak előrejelzésével, hogy ki követheti el őket - egy ellentmondásos megközelítés, amelyet Chicago város épített a legvalószínűbben bevont emberek „stratégiai tárgylista” köré. a jövőbeli lövésekben, akár lövőként, akár áldozatként.

Az American Civil Liberties Union [ACLU], a Brennan Igazságszolgáltatási Központ és a különféle polgári jogi szervezetek mind felvettek kérdéseket a szoftverben elfogult előítélet kockázatával kapcsolatban. A kritikusok állítása szerint a rendõri gyakorlatok történelmi adatai visszajelzési hurkot hozhatnak létre, amelyen keresztül az algoritmusok olyan döntéseket hoznak, amelyek tükrözik és megerõsítik a hozzáállást attól, hogy mely körzetek „rosszak” és melyek „jók”. Ez az oka annak, hogy az elsõdlegesen a letartóztatásokra alapozott AI magasabb az elfogultság kockázata - jobban tükrözi a rendõrségi döntéseket, szemben a ténylegesen bejelentett bûncselekményekkel. Például a CrimeScan tartózkodik azon bűncselekmények előrejelzésének próbálkozásától, amelyek Neill szerint: „Csak akkor fogja megtalálni, ha rájuk keres.”

"Nem mondhatom, hogy mentesek vagyunk torzításoktól" - mondja Neill -, de ez minden bizonnyal enyhébb, mint ha megpróbálnánk megjósolni a kábítószer-birtoklást.

Akkor ott van a visszajelzési hurok másik oldala. Ha egy prediktív eszköz felveti a várakozást egy bizonyos környéken elkövetett bűncselekményekkel kapcsolatban, akkor az ott járőröző rendőrség agresszívabb lesz-e a letartóztatások során?

„Bármilyen adatvezérelt rendszabályozással valódi veszély fennáll annak elfelejtése, hogy az egyenlet mindkét oldalán emberek vannak” - jegyzi meg Andrew Ferguson, a Columbia Kerületi Egyetem jogi professzora és a könyv, A nagy adatgyűjtés növekedése: megfigyelés, verseny és a bűnüldözés jövője. „A tiszteknek képesnek kell lenniük lefordítani ezeket az ötleteket, amelyek arra utalnak, hogy a különböző környékek eltérő veszélyességi pontszámokat mutatnak. És ha az előtte lévő ember helyett a számokra összpontosít, megváltozik a velük való kapcsolat.

A fekete dobozban

A valóság az, hogy a mesterséges intelligencia ma - bár gyakran a háttérben - számos szerepet játszik a mindennapi életet érintő számos döntésben - a vállalkozások kiválasztásának elősegítésében a felvételtől a hitelképességi pontok meghatározásáig a tanárok értékeléséig. Nem meglepő, hogy ez fokozta a gépi tanulási algoritmusok létrehozásának, a nem szándékos következményeknek az okainak nyilvános ellenőrzését, és miért nem vizsgálják őket általában sok szempontból.

A kezdők számára a szoftver nagy része védett, így az algoritmusok működése kevés átláthatóságot mutat. És ahogy a gépi tanulás kifinomultabbá válik, még az AI-rendszert létrehozó mérnökök számára is egyre nehezebb lesz magyarázni az általa választott döntéseket. Ez az átláthatatlan, kevés elszámoltathatósággal járó döntéshozatal annak a következménye, amelyet „fekete doboz” algoritmusnak hívnak.

"A nyilvánosság soha nem kap esélyt az ilyen rendszerek használatának ellenőrzésére vagy megvitatására" - mondja Meredith Whittaker, az AI Now Institute egyik alapítója, a New York-i Egyetem kutatási szervezetének, amely az AI társadalmi hatására összpontosít. "És az előrejelzéseket irányító adatok és logika gyakran még azok számára sem ismeretes, akik használják őket, nem is beszélve az embereknek, akiknek az életét befolyásolják."

A múlt ősszel kiadott jelentésben az AI Now elérte azt a javaslatot, hogy a büntető igazságszolgáltatás, az egészségügy, a jóléti és oktatási ügyekért felelős állami ügynökségek ne használják a fekete doboz AI rendszereket. Az AI Now szerint ritkán vannak jogi és etikai kérdések, amelyekre nagy figyelmet fordítanak a szoftver létrehozásakor.

"Ugyanúgy, ahogy nem bízná meg a bírót egy mély idegi hálózat felépítésében, ne hagyjuk abba a feltételezést, hogy a mérnöki diploma elegendő komplex döntések meghozatalához olyan területeken, mint a büntető igazságszolgáltatás" - mondja Whittaker.

Egy másik szervezet, a Demokrácia és Technológia Központ létrehozott egy „digitális döntések” eszközét, amely segít a mérnököknek és a számítógépes tudósoknak algoritmusok létrehozásában, amelyek igazságos és elfogulatlan eredményeket eredményeznek. Az eszköz sok kérdést feltesz, amelyek célja, hogy felmérjék feltételezéseiket és azonosítsák az előre nem látható hullámozási hatásokat.

"Szeretnénk adni az embereknek egy konkrét kiindulási pontot az olyan kérdések átgondolásához, mint például az, hogy mennyire reprezentatívak az adatok, melyik embercsoportot hagyhatják ki, és hogy modelljeik eredményei nem szándékos negatív következményekkel járnak-e" - mondta Natasha Duarte, aki felügyeli. a projekt.

Ki felelős?

Miközben erőfeszítéseket tettek arra, hogy a fejlesztők jobban megismerjék algoritmusaik esetleges következményeit, mások rámutattak, hogy az AI-re támaszkodó állami ügynökségeknek és cégeknek is elszámoltathatónak kell lenniük.

„Hangsúly van a tervezőknek a rendszer megértésére. De a rendszer adminisztrátora és végrehajtója iránt is szól. ”- mondja Jason Schultz, a New York-i Egyetem jogi professzora, aki az AI Now Institute-val együttműködik jogi és politikai kérdésekben. "A gumi itt felel meg az útnak az elszámoltathatóság szempontjából. Az AI-t használó kormányzati ügynökségek a legnagyobb felelősséggel tartoznak, és nekik is meg kell értenie azt. Ha nem érti a technológiát, akkor nem szabad használni."

E célból az AI Now támogatja az „algoritmikus hatásvizsgálat” használatát, amely megköveteli az állami ügynökségektől, hogy tegyék nyilvánosságra az általuk használt rendszereket, és lehetővé tegyék a külső kutatók számára, hogy elemezzék őket a lehetséges problémákra. A rendõri szervekkel kapcsolatban egyes jogi szakértõk szerint fontos az is, hogy világosan megfogalmazzák, hogyan használják a technológiát, és hajlandóak megosztani azt a helyi közösséggel.

"Ha ezeket a rendszereket az elszámoltathatóság, a méltányosság és a megfelelő eljárás szempontjából tervezték, akkor a rendszert végrehajtó személynek meg kell értenie, hogy felelősséggel tartozik" - mondja Schultz. "És amikor megtervezzük, hogyan fogjuk ezeket végrehajtani, az egyik első kérdés a következő:" Hová kerül ez a rendőri kézikönyvben? " Ha nem akarja ezt valahol a rendőrségi kézikönyvben, akkor lépjünk vissza, emberek. "

Andrew Ferguson látja, hogy szükség van arra, amit „megfigyelési csúcstalálkozónak” nevez.

"Legalább évente egyszer minden helyi illetékességben biztosítani kell a rendőrségi technológia elszámoltathatóságát" - mondja. „A rendőrfõnöknek, a polgármesternek vagy esetleg a városi tanács vezetõjének el kellene magyaráznia a közösségnek, hogy mire használják az adófizetõi dollárt a megfigyelés és a technológia szempontjából, miért gondolják, hogy ez a pénz megfelelõ felhasználása, amit ellenőrzi és megóvja az adatokat, mi a magánélet következményei. És a közösség ott lenne, hogy kérdéseket tegyen fel. ”

Daniel Neill, a CrimeScan alkotója azt állítja, hogy nem kifogásolja az AI eredmények rendszeres ellenőrzésének gondolatát, bár fenntartásait fejezi ki amiatt, hogy ezt még azelőtt végezzék el, hogy egy algoritmust megfelelő módon tesztelnek. Jelenleg a Pittsburghi Rendőrségi Hivatallal dolgozik egy CrimeScan tárgyaláson, és legalábbis kezdetben volt kihívás azzal, hogy „megszerezzék a megfelelő járőrőrséget az előrejelzett forró pontokhoz”.

Azt mondja, hogy ez egy tanulási folyamat, amelynek célja a CrimeScan adaptálása oly módon, hogy az utcai rendőrök úgy gondolja, hogy ez hasznos. "Meg kell mutatnunk, hogy nemcsak előre tudjuk jósolni a bűncselekményt, hanem azt is, hogy valóban megakadályozzuk azt" - jegyzi meg Neill. "Ha csak dobja a szerszámot a falon, és reméli a legjobbakat, akkor az soha nem működik ilyen jól."

Elismeri annak kockázatát is, hogy egy algoritmust túlságosan elhalasztanak.

"Egy eszköz segíthet a rendőröknek jó döntéseket hozni" - mondja. „Nem hiszem, hogy a gépeknek kellene döntéseket hozniuk. Ezeket a döntések támogatására kell felhasználni. "

Neill hozzáteszi: "Megértem, hogy a gyakorlatban ez nem valami olyan történik, ami állandóan megtörténik."