Amint az emléknap minden évben emlékeztet bennünket, a háború nem szűnik meg.

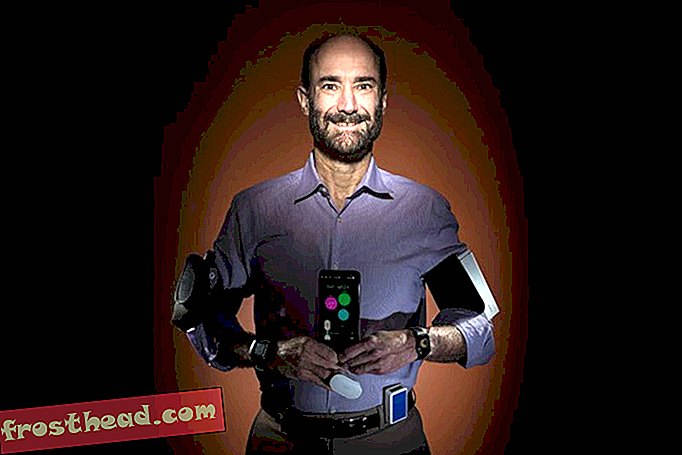

De megváltozik. Az egyik mélyebb váltás, amelyet az elkövetkező években látunk, az egyre inkább a robotoktól függő katonaság. A drogok most a legtöbb figyelmet kapják, de a Védelmi Minisztérium újításai egyre inkább más típusú pilóta nélküli gépeket jelentenek, a kísérleti repülőgépektől a földi katonákig.

Könnyű megérteni a vonzerőt. A robotok használata potenciálisan hatékonyabb, pontosabb és olcsóbb, mint a hadviselés során kizárólag az emberekre támaszkodni. És ez természetesen kevesebb emberi veszteséget is jelent.

De ez az átalakulás összetett kihívást jelent: A katonai gépek programozhatók-e a döntések meghozatalához? Ami ragaszkodóbb kérdéshez vezet: megtanulhatnak-e a robotok az erkölcsöt?

Az Egyesült Államok Haditengerészeti Kutatóintézete szerint most itt az ideje, hogy megtudja. A hónap elején bejelentette egy ötéves, 7, 5 millió dolláros támogatást a Tufts, a Brown, a Yale és a Georgetown egyetemen és a Rensselaer Politechnikai Intézetben (RPI) folytatott kutatások finanszírozására, arról, hogy a gépek egy nap képesek-e választani a rosszból.

A Haditengerészet el akarja kerülni azt a helyzetet, amelyet a Google vezetés nélküli autója most szembesül: olyan technológiával rendelkezik, amely messze megjelent a felmerülő jogi és etikai kérdések tisztázása előtt. Mielőtt az önálló robotok kijönnek a terepre, a katonaság meg akarja tudni, hogy megtanulják-e valóban helyesen cselekedni.

Ahogyan Selmer Bringsjord, az RPI Kognitív Tudományos Osztályának vezetője látja, egy robot mesterséges intelligenciáját úgy lehet megtervezni, hogy az az erkölcs két szintjén működjön. Az első egyértelmű etikai döntések ellenőrző listáján alapulna, mint például: „ha megsebesült katonaval találkozol, segíts neki.” De mi lenne, ha ez a fellépés ellentétes annak elsődleges küldetésével, mint például a más katonák? Ezen a ponton - mondja Bringsjord - a robotnak képesnek kell lennie arra, hogy „mélyebb erkölcsi érvelésben” részt vegyen, hogy döntéseket hozzon olyan helyzetekben, amelyeket a programozók nem tudtak előre látni.

A kutatóknak egyedi algoritmusokat és számítási mechanizmusokat kell kidolgozniuk, amelyeket be lehet építeni az autonóm robotok meglévő architektúrájába. Ez egy olyan „gondolkodási folyamat”, amely lehetővé teszi a gép számára, hogy felülbírálja a tervezett viselkedést az erkölcsi érvelés képessége alapján.

Ha ez rendkívül ambiciózusnak tűnik, akkor az az. Először a kutatóknak el kell különíteniük az emberi erkölcs alapvető elemeit - mely alapelvekben vagyunk egyetértésben? -, majd kitalálni, hogyan lehet azokat beépíteni olyan algoritmusokba, amelyek a robotoknak bizonyos szintű erkölcsi kompetenciát adnának.

Ez nem kis vállalkozás. Ezért valószínű, hogy az emberek által nem irányított gépek a belátható jövőben nem harci szerepekre korlátozódnak, mint például megfigyelés, biztonság, kutatás és mentés vagy orvosi ellátás. De a katonai tervezők elkerülhetetlenül választ akarnak kapni a kérdésre, amely mindezek felett áll: vajon a robotoknak, akik maguk viselkednek, meg kell engedniük egy ember megölését?

Ha egy gép 90 százalékkal biztos abban, hogy a lőni szándékozott járműben mindenki terrorista, akkor elég biztos? Képes-e egy robot lőni egy fegyvert egy gyermeknél, ha megállapítja, hogy ellenség? Ha valami baj történik, és egy önálló robot tévesen felrobbant egy falut, ki a felelős? A parancsnok, aki elrendelte a műveletet? Az a személy, aki programozta a robotot? Vagy senki?

Ha úgy gondolja, hogy ez még mindig a tudományos fantasztikus cikk, vegye figyelembe, hogy a hónap elején az Egyesült Nemzetek Szervezetének genfi konferenciáján a gyilkosrobotokkal foglalkoztak a mesterséges intelligenciától az emberi jogoktól a nemzetközi jogig terjedő témájú szakértők. Az olyan csoportok, mint az Human Rights Watch, valamint néhány ország tisztviselői, köztük Pakisztán, Egyiptom, Kuba és a Vatikán, a gyilkossággal felruházott robotok végleges tiltására szólítottak fel. De a legtöbb ország, különösen azok, amelyekben a legfejlettebb robotok vannak, még nem állnak készen arra, hogy ilyen messzire menjenek.

Vessen egy pillantást például a WildCat-ra, egy négylábú robotra, amelyet nagy sebességgel történő futtatáshoz fejlesztenek ki bármilyen terepen.

Az amerikai katonaság egyelőre a 2012. évi Védelmi Minisztérium irányelvét követi, amely szerint egyetlen megölni képes gép sem lehet teljesen autonóm. Az embernek szó szerint ki kell hívnia a lövéseket. De ez valószínűleg nem igaz minden helyre: Márciusban az New Scientist egy orosz tisztviselőt idézte, mondván, hogy az öt ballisztikusrakéta-létesítménynél lévő robot-őrzők képesek lesznek észlelni és megsemmisíteni a célokat anélkül, hogy az ember megadná a lépést.

Az alább látható Foster-Miller Talon az egyik a világon számos harcra kifejlesztett gépének.

A háború szabályai

A gyilkosrobot-konferenciáról szóló jelentést novemberben mutatják be az ENSZ Biztonsági Bizottságának. De úgy tűnik, hogy a tilalom hamarosan megjelenik.

A genfi vitába csatlakozók között szerepelt Ronald Arkin, a Georgia Tech mesterséges intelligencia szakértője, aki már régóta támogatója annak, hogy a gépek képesek legyenek erkölcsi döntéseket hozni. Úgy véli, hogy ha a robotok megtanulják követni a nemzetközi jogot, akkor valójában etikusabban viselkedhetnek, mint az emberek a hadviselésben, mert rendkívül következetesek lennének. Nem tudnának haraggal, pánikkal vagy előítélettel reagálni. Tehát Arkin ellenzi a tilalmat, noha nyitva áll az autonóm fegyverek moratóriumáig, amíg a gépek nem kapnak lehetőséget arra, hogy megtudják, képesek-e megtanulni a háború szabályait.

Egy másik AL tudós, Noel Sharkey, aki Genfben vitatta Arkinot, egészen más gondolkodású. Nem gondolja, hogy a robotoknak valaha felhatalmazást kell kapniuk az életre vagy halálra vonatkozó döntések meghozatalához.

Nemrégiben elmondta a Defense One-nak : „Nem hiszem, hogy valaha erkölcsi vagy etikai robotokkal fognak végezni. Ehhez szükségünk van erkölcsi ügynökségre. Ehhez meg kell értenünk másokat és tudnunk kell, mit jelent szenvedés. "

"Lehet, hogy egy robot be van építve bizonyos etikai szabályokkal, de ez nem igazán érdekel" - mondja.